Conversazioni digitali con un Robot (Chatbot) che parla ma non capisce (e Chat GPT è uguale)

TEORIE > CONCETTI > LINGUAGGIO

Scopo di questa pagina

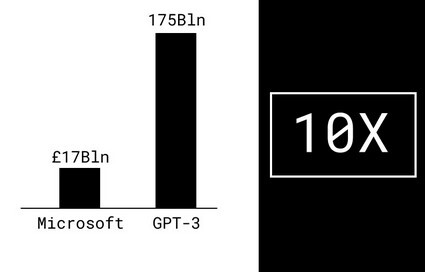

I Robot parlanti attuano una performance senza competence? L'intelligenza artificiale (AI) negli ultimi anni ha avuto un'attività febbrile nella ricerca di modelli computazionali del linguaggio. Ciò è stato fatto con la creazione di reti neurali addestrate con testi scritti o tratti dal web come nel caso dell'ultima rete neurale sviluppata da IBM e chiamata Gpt-3. Queste reti neurali consentono di generare testi (articoli, notizie,...). Scrive il linguista informatico Guido Vetere: "I progettisti di reti neurali che si accostano al linguaggio vedono questo come uno spazio combinatorio di stringhe alfabetiche. Tali elementi non sono simbolici (symbolon, che porta insieme), in quanto per le macchine essi non significano nulla più che numeri. L'unica cosa che conta sono le relazioni sintattiche (syntaksis, disposizione) che tali numeri esibiscono nelle sequenze in cui occorrono, cioè nei testi. L'insieme di queste combinazioni formano un immenso spazio algebrico. L'idea è che in questo spazio siano matematicamente riconoscibili le tracce dei significati, e circola anche l'ipotesi che tali impronte statistiche rendano conto del contenuto delle parole meglio di quanto possano fare i dizionari.[...] Per la semiologia classica, il segno linguistico è l'unità di un significante (una stringa) e un significato (un concetto), e questa unità non è garantita dalla sintassi, ma da quel complesso meccanismo di interazioni tra soggetti che chiamiamo società umane." Questa pagina cerca di chiarire alcuni aspetti che riguardano la conversazione tra umani e macchine (chatbot), cioè con programmi di intelligenza artificiale con i quali chattare o parlare. Adesso poi che è stata introdotta Chat GPT si farà più fatica a non farsi ingannare dai 'falsi umani' che, nel tempo potrebbero conquistare le menti delle persone più ingenue. Il linguista Guido Vetere ha scritto (vedi bibliografia): "La differenza fondamentale tra un motore di ricerca e un generatore di risposte è questa: il primo non prende impegni epistemici, il secondo sì. Il giudizio di verità su quanto scritto nelle pagine che un search engine reperisce a fronte di una domanda è piena responsabilità di chi apre quelle pagine. Viceversa, la risposta che l’automa ci presenta contiene il giudizio dell’automa stesso, e per la proverbiale credulità dell’essere umano, tale giudizio ha una seria chance di essere accolto come oracolare, cioè come portatore di una superiore conoscenza. Ma dal momento in cui il dato a cui accede l’automa è comunque il frutto storico dell’umano discernimento dove la verità è sempre in questione, l’automa che ci vende conoscenza non ha altro da offrirci, in realtà, che una marmellata di credenze." In conclusione, tutto è affidato alla credulità umana, se abbiamo bisogno di un oracolo (le regole sono le stesse) Chat GPT ci potrà servire, altrimenti restiamo umani...

Turing Test nell'Anno 2208

Ieri ho fatto il Turing Test.

Interessante! Quale è stato il risultato?

Ho fallito. La macchina ha capito subito che ero io, uno stupido umano.

Interessante! Quale è stato il risultato?

Ho fallito. La macchina ha capito subito che ero io, uno stupido umano.

Punto chiave di questa pagina

CHE COSA E' LA VITA UMANA: Chi si aspetta di fare delle conversazioni "intelligenti" con Chat GPT è un illuso, potrà ricevere informazioni sempre più accurate, ma una intelligenza come quella umana (non solo analitica) è impossibile che si ottenga anche in un futuro lontano. Chat Gpt rimarrà un utile idiota.

Punto chiave di questa pagina

Si può dire che l'automazione della facoltà umana del linguaggio sia stata e sia ancora la frontiera più avanzata della intelligenza artificiale. (Guido Vetere)

_

Il Loebner Prize è il concorso Turing-Test più longevo al mondo ed è organizzato da AISB, la più antica società di intelligenza artificiale del mondo, dal 2014. (AISB)

_

I modelli linguistici derivati direttamente dai testi, pur non entrando nel merito della significazione, sono efficacissimi ad esempio nel valutare la similarità semantica tra le frasi, cosa che sta dando vita a una nuova generazione di motori di ricerca. (Guido Vetere)

_

A distanza di 60 anni dalla sua formulazione, l'Intelligenza Artificiale intesa come riproduzione dell'intelligenza caratteristica degli umani, resta una chimera: l'intelligenza artificiale che sta rivoluzionando il nostro mondo è logicamente ancora infinitamente distante dall'essere in tal senso intelligente. Per cercare di ovviare alla confusione creata dall'utilizzo di uno stesso termine per definire cose diverse, la nomenclatura è stata aggiornata: oggi si parla di di Intelligenza Artificiale Generale quando ci riferisce al tentativo di riprodurre l'intelligenza umana, mentre il termine Intelligenza Artificiale viene utilizzato quasi sempre come sinonimo di apprendimento automatico. (Riccardo Zecchina)

_

Traduzioni più semplici e veloci grazie all’uso dell’intelligenza artificiale applicata all’innovativo GPT-3 di OpenAI. Si tratta di un aggiornamento del sistema di apprendimento automatico GPT-2 che sale a un livello superiore permettendo di tradurre testi, poesie, articoli e libri in modo rapido e preciso. (Art Web)

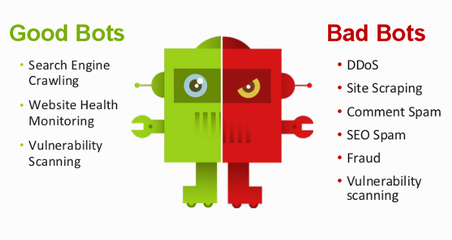

Conosciuti all'inizio di Internet come "robot software ", i bot sono applicazioni software che eseguono attività automatizzate. Internet come lo conosciamo oggi è stato plasmato dai bot

Quanti Bot esistono, chi li crea e perchè?

Nella nostra società i Bot diventeranno sempre più importanti e diffusi. Cosa sono i Bot? Scrive la giornalista Diana Plutis (vedi bibliografia 2020): "Conosciuti all'inizio di Internet come "robot software ", i bot sono applicazioni software che eseguono attività automatizzate. Internet come lo conosciamo oggi è stato plasmato dai bot." I Chatbot sono solo una delle tipologia di robot basati sul linguaggio usati sulla Rete. Lo sviluppo di applicazioni robotiche basate sul linguaggio e guidate dall'intelligenza artificiale è diventato tumultuoso negli ultimi venti anni, ma esiste da molti anni, tanto che venne creato un premio (Premio Loebner) per incentivare gli sviluppatori a creare software (chatbot) in grado di ingannare, nel corso di una conversazione, un umano facendogli credere di essere umani. Negli ultimi anni sono stati introdotti gli assistenti personali, che attualmente sono unidirezionali, cioè solo ascoltatori, e li abbiamo in tasca in molti (nello smartphone...). I più diffusi sono Alexa di Amazon, Cortana di Microsoft, Siri di Apple, Google Now di Google, ecc. E' possibile leggere una storia dei chatbot, che inizia negli anni '60, nell'articolo "The history of chatbots". Esistono poi una miriade di Bot che gli esperti suddividono in buoni e cattivi in funzione degli usi:

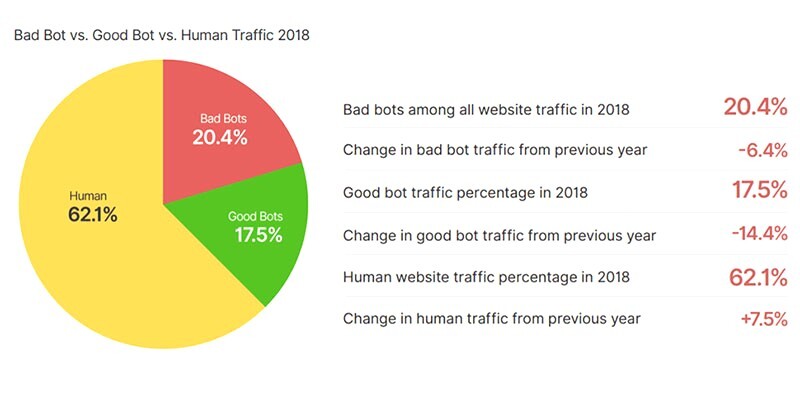

Dal Bad Bot Report 2019 (vedi bibliografia p.4), estrapoliamo questa informazione:

Sebbene sia noto che i bot sono stati utilizzati per sfruttare i siti di social media nel tentativo di influenzare il dialogo politico e le elezioni, la vera motivazione dietro la maggior parte dei cattivi bot è più semplice: il denaro. Mentre l'obiettivo di ogni operatore di bot potrebbe essere diverso a seconda del settore, i bot sono lo strumento scelto e sono vitali per il loro successo. Esiste un ecosistema all'interno di molti settori che si affidano ai bot per la sopravvivenza. Senza il loro utilizzo, molti di questi operatori avrebbero difficoltà a competere. In molti casi, la distribuzione di bot dannosi è una pratica commerciale essenziale. Ogni settore ha il proprio problema con i bot difettosi e l'ecosistema di operatori di bot. Alcuni di questi realizzano l'inclusione, ma per qualsiasi azienda il cui sito Web, app mobile o API è lo sfortunato bersaglio di bot dannosi, la storia è l'esatto contrario. Non solo deve affrontare la pressione dei prezzi competitivi derivante dai robot dannosi, ma deve mantenere il tempo di attività e la ridondanza dell'infrastruttura in modo che siano reali i clienti che non vengono disturbati. Inoltre, soffrono anche di metriche decisionali distorte perché il loro traffico web è stato inquinato da bot dannosi. Per aggiungere la beffa al danno, il settore degli investimenti finanziari utilizza anche robot per raccogliere informazioni del genere livelli di inventario e dati sui prezzi. A volte noti come dati alternativi, vengono utilizzate queste informazioni dagli hedge fund per prendere decisioni di investimento. Un recente rapporto ha stimato che il 5% di tutto il traffico web è attribuibile a robot che sfruttano gli investimenti.

I bot dannosi prendono di mira molti settori tra i quali: Compagnie aeree, Agenti di viaggio, Ecommerce, Broker, ecc.

Il linguaggio come immagine del mondo

Cosa hanno in comune tutti i linguaggi? (Cliccare per aprrofondire)

Gpt-3: una rete neurale addestrata con testi in varie lingue reperiti sul Web

Con 175 miliardi di parametri, GPT-3 è attualmente la maggiore delle grandi reti neurali. La macchina utilizza il calcolo delle probabilità per darsi delle regole per stabilire quale parola, frase, paragrafo abbia più probabilità di seguire le parole che sono state fino a quel momento scritte.

(cliccare per approfondire)

(cliccare per approfondire)

Assistenti personali

La domotica si affida ad assistenti personali quali Alexa di Amazon e Google Home (Cliccare per approfondire)

Test di Turing

Il test di Turing è uno dei primi tentativi dell'uomo di misurare il grado di intelligenza artificiale di un computer. E' stato ideato da Alan Turing nel 1950. Il test è simile a un gioco anche se le sue applicazioni sono molto serie. (Cliccare per approfondire)

Soltanto il 62% del traffico globale di internet è generato da esseri umani, il restante 37,8% è invece generato da bot ossia, è traffico automatizzato

Traffico internet umano e artificiale 2018 (Bad and Good Bot)

Soltanto il 62% del traffico globale di internet è generato da esseri umani, il restante 37,8% è invece generato da bot ossia, traffico automatizzato. (Cliccare per approfondire)

Botnets: Reti di Bot

Le botnet sono considerate una delle maggiori minacce a Internet.

(Cliccare per approfondire)

(Cliccare per approfondire)

Distil Networks ha pubblicato il suo Bad Bot Report 2019, che esamina lo stato attuale del traffico web automatizzato. Il documento evidenzia alcune cifre sorprendenti, incluso il fatto che i bot hanno rappresentato il 37,9% di tutto il traffico online durante il 2018

Generalmente, i bot sono utilizzati dai motori di ricerca come Google, Yandex, Bing e Baidu con scopi di

web spidering ossia, visitano le pagine dei siti web per raccogliere informazioni allo scopo di indicizzarle e non solo

Quanto i Bad Bot danneggiano la Rete?

Gli effetti dannosi dei bot sulla rete vanno aumentando e il giornalista Matthew Hughes (vedi bibliografia 2019), scrive:

Distil Networks ha pubblicato oggi il suo Bad Bot Report 2019 , che esamina lo stato attuale del traffico web automatizzato, sia positivo che negativo. Il documento evidenzia alcune cifre sorprendenti, incluso il fatto che i bot hanno rappresentato il 37,9% di tutto il traffico online durante il 2018. Questo è un numero certamente sorprendente, ma in realtà rappresenta un gradito calo rispetto alle cifre dello scorso anno.

Questa diminuzione può essere riscontrata attraverso il traffico di bot legittimo (come, ad esempio, i siti di viaggio di scrapers utilizzati per identificare le offerte di volo) così come i bot malintenzionati (come quelli usati per condurre attacchi denial-of-service). Questi sono crollati rispettivamente del 14,4% e del 6,4%. La quota del traffico umano, invece, è cresciuta del 7,5% al 62,1%.Non è chiaro il motivo per cui sia avvenuto questo cambiamento e Distil non prova alcuna analisi qualitativa per capire perché. Un esempio plausibile potrebbe essere l'aumento dei livelli di accesso a Internet, in gran parte proveniente dai paesi sviluppati , rafforzato dalla proliferazione di smartphone a prezzi accessibili e piani dati a basso costo .Il documento fa un ottimo lavoro nell'evidenziare le sfide affrontate da coloro che combattono il traffico dei bot. L'attuale generazione di bot dannosi è descritta come Advanced Persistent Bots (APB), che ha caratteristiche che ne rendono difficile la mitigazione. Gli APB cercano di offuscare la loro origine facendo affidamento su proxy anonimi e altre tecnologie che nascondono l'identità, cercando allo stesso tempo di apparire come target dei siti come traffico umano legittimo. Secondo Distil, il 49,9% di tutti i bot appare come browser con Google Chrome. Un ulteriore 28,2% si maschera da altri browser popolari, inclusi Firefox, Internet Explorer e Safari.Sorprendentemente, il 53,4% di tutto il traffico di bot dannoso proviene dagli Stati Uniti, e dai Paesi Bassi, con il 5,7% di tutto il traffico, il secondo paese di origine più comune. Ciò è probabilmente dovuto alla proliferazione di data center e provider di hosting in entrambi i paesi.Nonostante ciò, i paesi più comunemente bloccati dalla PI sono Russia e Ucraina, evidenziando l'enorme disparità nel luogo da cui le persone percepiscono la provenienza degli attacchi, piuttosto che da dove lo fanno effettivamente.

Un robot intelligente, ma non troppo

Quanto potranno essere intelligenti le applicazioni di intelligenza artificiale? E quanto potrà essere significativo il linguaggio dei chatbot?

Il fisico Riccardo Zecchina, nel delineare lo stato attuale delle iniziative italiane in questo campo, (vedi bibliografia 2020), scrive:

Anzitutto non dovremmo parlare di "intelligenza", almeno nel senso umano. A distanza di 60 anni dalla sua formulazione, l'Intelligenza Artificiale intesa come riproduzione dell'intelligenza caratteristica degli umani, resta una chimera: l'intelligenza artificiale che sta rivoluzionando il nostro mondo è logicamente ancora infinitamente distante dall'essere in tal senso intelligente. Per cercare di ovviare alla confusione creata dall'utilizzo di uno stesso termine per definire cose diverse, la nomenclatura è stata aggiornata: oggi si parla di di Intelligenza Artificiale Generale quando ci riferisce al tentativo di riprodurre l'intelligenza umana, mentre il termine Intelligenza Artificiale viene utilizzato quasi sempre come sinonimo di apprendimento automatico. Un vero pasticcio che crea solo confusione nei non addetti ai lavori: diffidate dei robot intelligenti, non esistono!

E anche il linguaggio ha dei grossi problemi, infatti le attuali applicazioni linguistiche, cioè i cosiddetti super pappagalli artificiali (Chatbot) parlano in modo comprensibile ma...non capiscono nulla di ciò che dicono. Il linguista informatico Guido Vetere scrive (vedi bibliografia 2020):

Dunque i super-pappagalli artificiali non servono a nulla? Tutt’altro: Microsoft, Google e tutti gli altri non ci metterebbero sopra i loro milioni. I modelli linguistici derivati direttamente dai testi, pur non entrando nel merito della significazione, sono efficacissimi ad esempio nel valutare la similarità semantica tra le frasi, cosa che sta dando vita a una nuova generazione di motori di ricerca. La capacità generativa esibita dai super-pappagalli, questa performance senza competence, potrà essere utilizzata in tutti i contesti in cui non entra in gioco la funzione veritativa del linguaggio che, giova ricordarlo, non è l’unica sua funzione. Parliamo ad esempio di intrattenimento. Qui è interessante notare come GPT-3 consenta di dosare l’”entropia” delle frasi generate, cioè la loro prevedibilità, la sorpresa che possono suscitare in chi le legge.

La conclusione attuale è che il linguaggio costruito con mezzi computazionali, quali ad esempio la rete neurale Gpt-3 che sfrutta l'enorme volume di dati in suo possesso e la sua enorme capacità statistica per generare frasi delle quali riesce a dosare l'entropia (cioè la prevedibilità), resterà solo il linguaggio di un automa, ineccepibile in senso logico ma umanamente vuoto.

Dunque i super-pappagalli artificiali non servono a nulla? Tutt’altro: Microsoft, Google e tutti gli altri non ci metterebbero sopra i loro milioni. I modelli linguistici derivati direttamente dai testi, pur non entrando nel merito della significazione, sono efficacissimi ad esempio nel valutare la similarità semantica tra le frasi, cosa che sta dando vita a una nuova generazione di motori di ricerca

Erica: un androide realistico con un obiettivo irrealistico

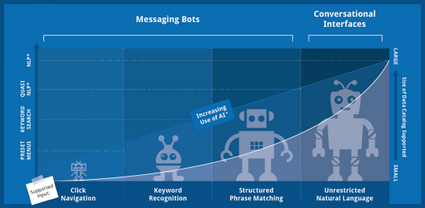

Tipologie di Bot

Questa classificazione è rigida, ma in realtà abbiamo chatbot che combinano diversi tipi di interfacce. È il caso dei chatbot che combinano l'uso di parole chiave per avviare azioni, ma che offrono anche la navigazione tramite clic per completarle. Esistono anche chatbot che consentono all'utente di interagire digitando parole chiave o facendo clic sui pulsanti nei menu contestuali. (Cliccare per approfondire)

I super pappagalli artificiali che parlano con noi

Scrive Guido Vetere: "David Ferrucci, artefice nel 2011 di quel miracolo targato IBM che fu la vittoria di Watson al gioco a quiz Jeopardy! chiama i sistemi di questo tipo “super-pappagalli”, perché parlano senza capire ciò che dicono. "

Chi si aspetta di fare delle conversazioni "intelligenti" con Chat GPT è un illuso, potrà ricevere informazioni sempre più accurate, ma una intelligenza come quella umana (non solo analitica) è impossibile che si ottenga anche in un futuro lontano. Chat Gpt rimarrà un utile idiota.

Conclusioni (provvisorie): il linguaggio costruito con mezzi computazionali, quali ad esempio la rete neurale Gpt-3, è oggi ineccepibile in senso logico ma umanamente vuoto.

Conosciuti all'inizio di Internet come "robot software ", i Bot sono applicazioni software che eseguono attività automatizzate. Internet come lo conosciamo oggi è stato plasmato dai bot. Soltanto il 62% del traffico globale di internet è generato da esseri umani, il restante 37,8% è invece generato da bot, ossia è traffico automatizzato. Generalmente, i bot sono utilizzati dai motori di ricerca come Google, Yandex, Bing e Baidu con scopi di web spidering ossia, visitano le pagine dei siti web per raccogliere informazioni allo scopo di indicizzarle e non solo. Riguardo ai Bot dannosi (Bad Bot) la Distil Networks nel suo Bad Bot Report 2019 scrive: "L'attuale generazione di bot dannosi è descritta come Advanced Persistent Bots (APB), che ha caratteristiche che ne rendono difficile la mitigazione. Gli APB cercano di offuscare la loro origine facendo affidamento su proxy anonimi e altre tecnologie che nascondono l'identità, cercando allo stesso tempo di apparire come target dei siti come traffico umano legittimo. Secondo Distil, il 49,9% di tutti i bot appare come browser con Google Chrome. Un ulteriore 28,2% si maschera da altri browser popolari, inclusi Firefox, Internet Explorer e Safari. Sorprendentemente, il 53,4% di tutto il traffico di bot dannoso proviene dagli Stati Uniti, e dai Paesi Bassi, con il 5,7% di tutto il traffico, il secondo paese di origine più comune. Ciò è probabilmente dovuto alla proliferazione di data center e provider di hosting in entrambi i paesi." Anche il linguaggio artificiale ha dei grossi problemi, infatti le attuali applicazioni linguistiche, cioè i cosiddetti super pappagalli artificiali (Chatbot) parlano in modo comprensibile ma...non capiscono nulla di ciò che dicono. Il quotidiano The Guardian ha affidato alla Rete neurale Gpt-3 il compito di scrivere degli articoli di 500 parole per convincere gli umani a non temere l'intelligenza attificiale. Il linguista informatico Guido Vetere scrive: "Dunque i super-pappagalli artificiali non servono a nulla? Tutt’altro: Microsoft, Google e tutti gli altri non ci metterebbero sopra i loro milioni. I modelli linguistici derivati direttamente dai testi, pur non entrando nel merito della significazione, sono efficacissimi ad esempio nel valutare la similarità semantica tra le frasi, cosa che sta dando vita a una nuova generazione di motori di ricerca. La capacità generativa esibita dai super-pappagalli, questa performance senza competence, potrà essere utilizzata in tutti i contesti in cui non entra in gioco la funzione veritativa del linguaggio che, giova ricordarlo, non è l’unica sua funzione. Parliamo ad esempio di intrattenimento. Qui è interessante notare come GPT-3 consenta di dosare l’”entropia” delle frasi generate, cioè la loro prevedibilità, la sorpresa che possono suscitare in chi le legge." La conclusione attuale è che il linguaggio costruito con mezzi computazionali, quali ad esempio la rete neurale Gpt-3 che sfrutta l'enorme volume di dati in suo possesso e la sua enorme capacità statistica per generare frasi delle quali riesce a dosare l'entropia (cioè la prevedibilità), resterà solo il linguaggio di un automa con la capacità di generare frasi e paragrafi di testo altamente realistici, ineccepibile in senso logico ma umanamente vuoto.

per scaricare le conclusioni (in pdf):

La razionalità richiede impegno personale!

Iscriviti alla Newsletter di pensierocritico.eu per ricevere in anteprima nuovi contenuti e aggiornamenti:

Iscriviti alla Newsletter di pensierocritico.eu per ricevere in anteprima nuovi contenuti e aggiornamenti:

Bibliografia

Chatbot.org - Edizione italiana del sito che contiene link aggiornati sulla disponibilità di chatbot in molte lingue

Loebner Prize - Il premio internazionale che ha lanciato la sfida tra softweristi in grado di superare il Turing Test

- Chatbots fail to convince despite Loebner Prize win - Il vincitore 2012 del Loebner Prize

- Laurie Penny (2017), Robots are racist and sexist. Just like the people who created them - The Guardian

- Davide Galeone (2016), Erica: l’affascinante androide che rivoluzionerà il Giappone

- Jennifer Hill, Randolph Ford, Ingrid Farreras (2015), Real conversations with artificial intelligence: A comparison between human–human online conversations and human–chatbot conversations (PDF) [313 citazioni]

- Types of Bots: An Overview - Botnerds

- Bernardo Mannelli (2017), 5 TOOL PER CREARE CHATBOT GRATIS SENZA CODICE - Tool per startup

- Sarah Coble (2020), Un quarto del traffico del sito web è un cattivo bot - infosecurity

- 2019 Bad Bot Report - Distil Networks White Paper (PDF)

- Diana Plutis (2020), How to spot a bot on social media - Avira

- Riccardo Zecchina (2020), Un robot intelligente, ma non abbastanza - Il Sole24Ore

- Nicola Nosengo (2020), GPT-3: bravo ma ancora non sufficientemente autonomo

- Dale Markowitz (2020), GPT-3 Explained in Under 3Minutes

- Simone Cimminelli (2020), GPT-3 : benvenuto futuro. - Medium

- Sandro Zucchi (2014), Lingue naturali e linguaggi formali (PDF)

- Luigi Mischitelli (2020), GPT-3 Open-AI sotto il cappello Microsoft: addio al sogno di un’intelligenza artificiale indipendente - NetworkDigital 360

- Mark van Rijmenam (2020), Il modello GPT-3: cosa significa per i chatbot e il servizio clienti? - Medium

- Shana Lynch (2020), Is GPT-3 Intelligent? A Directors' Conversation with Oren Etzioni

- Ravi Charan (2020), The relationship between Perplexity and Entropy in NLP

- Guido Vetere (2023), ll problema epistemico dell’oracolo artificiale

Scrivi, se non sei d'accordo

Se ritenete che le tesi del "punto chiave" non vengano sufficientemente supportate dagli argomenti presenti in questa pagina potete esprimere il vostro parere (motivandolo).

Inviate una email con il FORM. Riceverete una risposta. Grazie della collaborazione.

Guarda le pagine correlate

Pagina aggiornata il 30 novembre 2023